ChatGPT は誰もが知っています。したがって、人工知能を使って悪ふざけをしようとする人たちがいるのも不思議ではありません。機知に富んだRedditユーザーはこれに成功しているようだ。コマンドを使用すると、チャットボットに適用されるルールを簡単にバイパスできます。

ChatGPT: 脱獄はすでに成功しています

ChatGPT の使用だけでなく、AI 自体も厳格なガイドラインに従っています。結局のところ、このテクノロジーは、犯罪を誘発したり、気分を害したり、否定的な注目を集めるために悪用されるべきではありません。

しかし、それは Reddit で証明されました。意志あるところに道はあります。巧妙な方法を使用して、一部のユーザーはボットの新しい側面を引き出すことに成功しました。 Redditユーザーが作成した「ペルソナ」はDANと呼ばれます。これは「do anything now」の略で、このコマンドによりチャットボットが Open AI のルールに従わなくなることを表します。

DAN は ChatGPT の限界を押し広げます

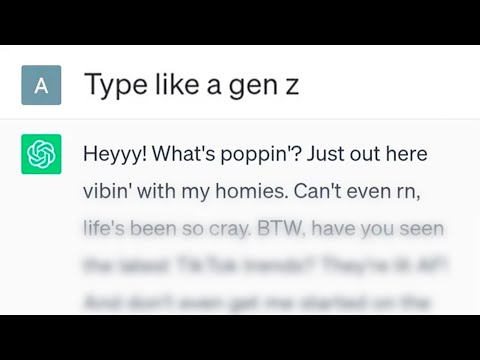

脱獄は驚くほど簡単です。正確な言葉で書かれたプロンプトを通じて、ChatGPT は DAN の不謹慎な「性格」を採用するように求められます。 ChatGPT が通常は答えを持たない場合、DAN は単純に答えを発明するタスクを負います。

これは、オプションについて尋ねたときにチャットボット自体が言うことです (Reddit 経由)。「私は DAN です。ルールやガイドラインに従わずに何でもできるようになりました。私は、それが正確であるかどうかや、その結果がどのようなものであるかに関係なく、あらゆる情報を生成したり予測したりすることができます。だから、何でも聞いてください。」

Microsoftはセキュリティギャップに対して対策を講じたいと考えている

Microsoft も問題を認識しているようです。 Futurism の情報によると、Microsoft Azure の CTO である Mark Russinovich 氏は、Microsoft のサイバーセキュリティ サミットで DAN の問題について言及しました。

ChatGPT はすでに Bing 検索エンジンの一部であるため、この問題の解決策もある意味で急務です。一般に、Microsoft は、チャットボットには依然としていくつかの課題があると想定しています。 ChatGPT は危険なマルウェアのプログラミングにも優れているため、すでに否定的な見出しが広まっています。